Inteligencia Artificial, Privacidad

El momento “DeepSeek” y lo que significa para la industria de la salud

Igor Alvarez - Chief Innovation Officer

Recientemente, DeepSeek ha estado ocupando titulares en todo el mundo, extendiéndose más allá de las noticias tecnológicas hacia los medios principales. Más allá de su significativo impacto en el mercado de NVIDIA y los gigantes tecnológicos de EE. UU., ¿qué significa esto para el resto de nosotros, particularmente en el sector sanitario? Para entender el impacto potencial de DeepSeek en nuestro sector, examinemos qué es, evaluemos las fortalezas y limitaciones de su modelo recientemente lanzado, r1, y determinemos cómo —o si— debemos usarlo en nuestros proyectos diarios, considerando las herramientas similares existentes en el mercado.

¿Qué es DeepSeek y qué es r1?

DeepSeek es una empresa china fundada en 2023 en Hangzhou que se centra en el desarrollo de IA y Modelos de Lenguaje de Gran Escala (LLM, por sus siglas en inglés). En noviembre de 2023, lanzaron su primer producto: DeepSeek Coder, una familia de modelos LLM de código abierto diseñados para generar código. Entrenado en más de 80 lenguajes de programación, alcanzó un rendimiento de vanguardia (SOTA, por sus siglas en inglés) en comparación con modelos similares. Desde entonces, DeepSeek ha lanzado consistentemente modelos de código abierto que han alcanzado el estatus SOTA en sus respectivas categorías. Sin embargo, estos modelos no estuvieron exentos de limitaciones. Por ejemplo, su DeepSeek LLM, lanzado en noviembre de 2023, podía competir con el modelo SOTA de ese entonces, GPT-4, pero enfrentaba desafíos de rendimiento y escalabilidad.

Tras numerosos lanzamientos de varios actores en el mercado de LLM (incluidos algunos de DeepSeek), OpenAI lanzó su nuevo modelo, o1, en diciembre de 2024. Este modelo prometía revolucionar cómo funcionan los LLM y la IA al “pensar” cada tarea metódicamente, cuestionando su enfoque en cada paso antes de ofrecer una respuesta final. Este enfoque innovador combinaba el razonamiento de Cadena de Pensamiento (CoT, por sus siglas en inglés) con la computación en tiempo de prueba. A diferencia de los modelos tradicionales que utilizaban la mayor parte de los recursos computacionales durante el entrenamiento, este nuevo enfoque también aprovechaba el poder computacional durante la fase de respuesta, produciendo resultados superiores a costa de mayores requisitos de recursos.

A pesar de un lanzamiento inicial lento y restringido, los resultados de o1 fueron superiores a sus predecesores como Claude Sonnet 3 y GPT-4o. Particularmente en tareas relacionadas con lógica, matemáticas y código, el modelo superó a todos los modelos anteriores y logró un rendimiento excepcional en varios benchmarks. Este éxito llevó a muchos escépticos, quienes habían predicho un nuevo “Invierno de IA”, a reconsiderar su posición. Sin embargo, el precio era considerable: acceder a la versión “pro” de o1 (con uso diario limitado) requería una suscripción a OpenAI de $200 al mes. Una versión más asequible, adecuada para la mayoría de los casos de uso, estaba disponible por $20, pero con limitaciones de uso.

¿En qué se diferencia DeepSeek r1?

DeepSeek r1, lanzado el 20 de enero de 2024, prometía resultados comparables a los de o1 de OpenAI a una fracción del costo. El modelo es actualmente gratuito para usar —incluso comercialmente— y tiene pesos abiertos, permitiendo a cualquiera descargar los modelos y ejecutarlos localmente. Publicado bajo una licencia MIT, venía con una interfaz de chat basada en web gratuita, aplicaciones para iOS y Android, y una familia de modelos más pequeños. Estas versiones más pequeñas, entrenadas en el modelo principal, pueden incluso ejecutarse en hardware de consumo estándar en casa, sin costo adicional.

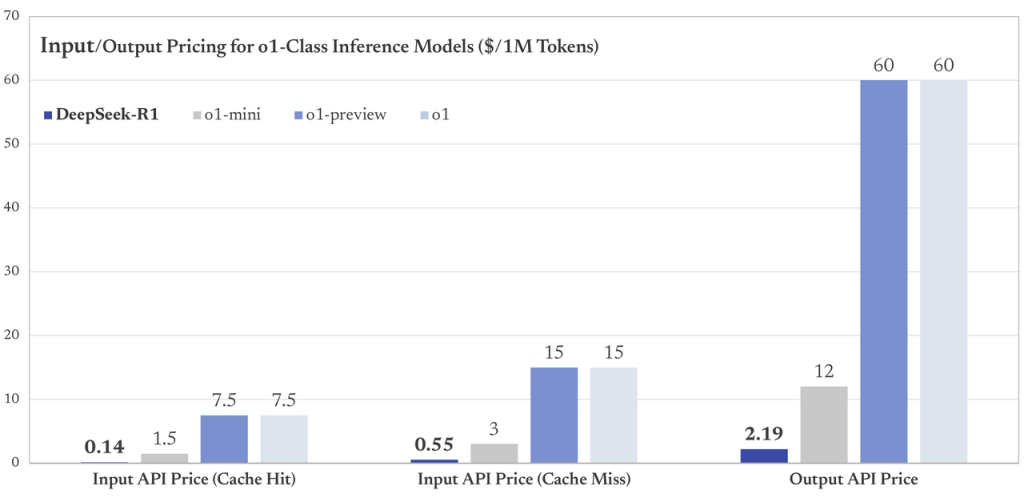

Incluso el acceso a la API orientada a desarrolladores cuesta significativamente menos que o1.

El acceso a la API de DeepSeek, el punto de acceso utilizado por programadores, cuesta solo una fracción de OpenAI o1:

Entrada: $0.55/1M Tokens frente a $15 para OpenAI o1 y Salida: $2.19/1M Tokens frente a $60 para OpenAI o1.

El acceso a la API de DeepSeek, el punto de acceso utilizado por programadores, cuesta solo una fracción de OpenAI o1: Entrada: $0.55/1M Tokens frente a $15 para OpenAI o1 y Salida: $2.19/1M Tokens frente a $60 para OpenAI o1.

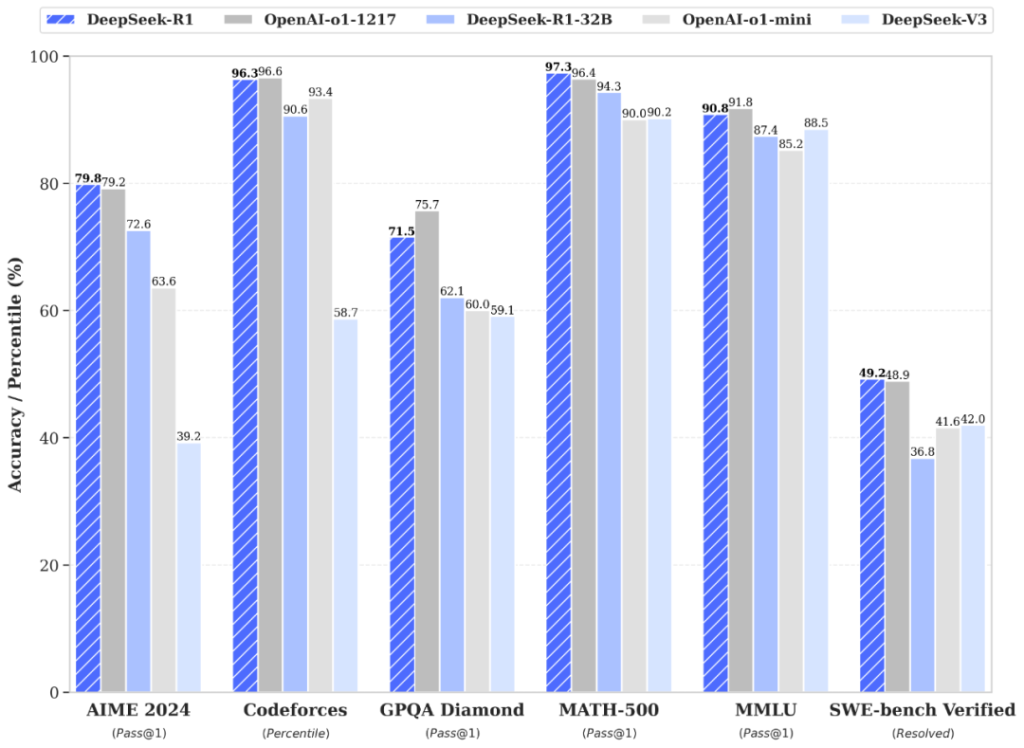

Un aspecto particularmente notable, y tal vez lo que causó un gran impacto en el mercado financiero, es la eficiencia de costos en el desarrollo de DeepSeek. Mientras que se informa que OpenAI invirtió $500 millones en el desarrollo de ‘GPT-5’ (Proyecto Orion) y mantiene costos operativos anuales estimados que superan los $3 mil millones, la inversión total en el entrenamiento de DeepSeek r1 fue de solo $5.6 millones. Pero, ¿qué tan capaz es r1 en términos de calidad? En la industria de la IA, las empresas evalúan las capacidades de sus modelos a través de pruebas estandarizadas de preguntas y respuestas llamadas “benchmarks”. Estas pruebas, creadas por expertos en el dominio, proporcionan una forma confiable de comparar modelos de diferentes empresas. A continuación, podemos ver algunos de los resultados de los benchmarks compartidos por el equipo de DeepSeek:

DeepSeek r1 supera a OpenAI o1 por un pequeño margen en 3/6 de los benchmarks mencionados, y obtiene resultados muy cercanos en los restantes.

Según estos benchmarks, DeepSeek r1 iguala o supera a OpenAI o1 en todas las pruebas. Incluso r1 32B, uno de los modelos más pequeños de la familia r1 diseñado para hardware de consumo, tiene un rendimiento igual o mejor que o1-mini. Pero, ¿qué significa esto en términos prácticos? ¿Y tiene r1 alguna limitación para tu uso diario?

El caso de r1 para el sector sanitario

El uso de IA y LLM en el sector sanitario está bien establecido, con numerosas aplicaciones comprobadas en diagnóstico, relaciones con pacientes y—como se cubrió en nuestro artículo anterior—incluso en investigación de descubrimiento de medicamentos. Pero examinemos cómo encaja r1 en este ecosistema y sus consideraciones específicas para aplicaciones sanitarias.

¿Hay algún problema de privacidad?

Al hablar de r1, la privacidad suele ser la primera preocupación, dado que DeepSeek es una empresa china que opera en China. Si bien estas preocupaciones son válidas en muchos contextos, r1 ofrece una ventaja única de privacidad y seguridad que incluso los modelos insignia de OpenAI y Google carecían anteriormente: como un modelo abierto, las organizaciones pueden alojarlo localmente en servidores dentro de territorios de EE. UU./UE, o incluso dentro de su propia empresa si tienen los recursos para hacerlo. Este enfoque facilita el manejo de PII (Información Personal Identificable) y datos médicos asegurando una privacidad completa y una seguridad mejorada, y puede incluso ser beneficioso para empresas que buscan aplicar cualquier pipeline de LLM a información secreta/interna. A diferencia del uso de LLM estándar a través de las API de OpenAI, Claude o Google, el alojamiento local garantiza que los datos sensibles NUNCA salgan de tu infraestructura ni se compartan con terceros.

¿Es fácil de implementar?

A pesar de su diferente “razonamiento” y enfoque de Cadena de Pensamiento, DeepSeek r1 sirve como una herramienta poderosa para cualquier aplicación donde normalmente usarías un LLM estándar. La transición al alojamiento propio y una implementación ligeramente diferente requiere un esfuerzo adicional mínimo. Nuestras pruebas recientes en tareas de clasificación de texto, programación y generación de contenido educativo han mostrado un rendimiento excepcional de r1, validando los benchmarks oficiales: el modelo resulta más confiable, lógico y capaz que sus predecesores.

¿Cómo puedo añadirlo a mis tareas/productos diarios?

Como todos los modelos LLM, r1 puede producir alucinaciones cuando su conocimiento es limitado, y sus respuestas no pueden garantizarse 100% precisas. Aunque las capacidades del modelo son impresionantes y su proceso de Cadena de Pensamiento ofrece transparencia, implementar medidas de seguridad adicionales sigue siendo crucial—como con cualquier herramienta basada en LLM.

En C/Edge, nuestro equipo integra tecnología LLM con RAGs (Generaciones Aumentadas por Recuperación), Llamadas de Función, Modelos de Seguridad, pipelines Agénticos y otras técnicas para abordar estos desafíos y optimizar el rendimiento para tu equipo o cliente. Nuestro objetivo va más allá de proporcionar una simple interfaz de chatbot: entregamos una solución integral basada en los datos del mundo real que elijas, que se alinee con las expectativas de tu marca.

¿Estás interesado en aprender más?

Estaré llevando a cabo una serie de webinars este año como el nuevo Director de Innovación de C/Edge. En estas sesiones, compartiré mi experiencia en tecnologías y nuevos desarrollos en el panorama digital para el mercado de comunicación y publicidad sanitaria. ¡Mantente atento para más información sobre las fechas y temas de los webinars!

Conclusión

DeepSeek r1 representa un hito significativo en el desarrollo de IA, no solo por sus logros técnicos, sino por lo que significa para el futuro de la industria sanitaria. Al combinar un rendimiento de vanguardia con una accesibilidad sin precedentes—tanto en términos de costo como de opciones de implementación—r1 tiene el potencial de democratizar las capacidades avanzadas de IA en todo el sector sanitario. Aunque la llegada del modelo ha generado discusiones sobre todo, desde la dinámica del mercado hasta preocupaciones de privacidad, sus beneficios prácticos para las organizaciones sanitarias son claros: la capacidad de aprovechar la tecnología de IA de punta sin comprometer la seguridad de los datos ni romper el presupuesto. Mientras continuamos explorando e implementando estas tecnologías en C/Edge, nuestro enfoque permanece en convertir estos avances tecnológicos en soluciones prácticas, seguras y efectivas para nuestros clientes sanitarios. La aparición de modelos como r1 sugiere que el futuro de la IA en el sector sanitario estará definido no solo por la capacidad, sino por la accesibilidad y la adaptabilidad a las necesidades reales del mundo sanitario.